« Avoir raison trop tôt est socialement inacceptable »

À trop se pencher sur le potentiel technique et économique de l’IA, un marché qui devrait selon un rapport de ResearchAndMarkets en date de 2021 représenter en 2027 pas moins de 1800 milliards de dollars. Il me semble raisonnable de postuler que c’est un secteur aussi prometteur que « dangereux » : l’argent et l’éthique faisant souvent difficilement bon ménage. Certes, et pour ce qui concerne l’UE, le 14 juin 2023 le Parlement européen a adopté la loi sur l’intelligence artificielle ! Cette loi louable en soi constitue le tout premier cadre réglementaire sur l’intelligence artificielle dans le monde. Le cadre adopté est supposé empêcher de multiples dévoiements jugés inacceptables notamment dans le domaine militaire (cf. robots tueurs), voire à terme mettre en danger notre humanité (Cf. L’IA Act : de l’IA générative à une superintelligence hors contrôle). Notons que d’autres réglementations sont en cours d’élaborations en Chine comme aux États-Unis. Qui dit multiplications de réglementations n’est pas vraiment de bon augure. Chacun comprendra que cela ne peut favoriser une harmonisation consensuelle des limites à imposer à cette technologie en fulgurante expansion.

Pour ceux et celles qui douteraient de cette assertion, la trouverait outrancière, je les invites à prendre connaissance de la déclaration de Vladimir Poutine en date du vendredi 1er septembre 2017. Ce jour, lors d’une conférence sur les nouvelles technologies à destination des étudiants russes, le Président Russe a annoncé sans ambages et de façon « visionnaire » – quoi que l’on pense de l’homme – que « Celui qui réalisera une percée marquante en intelligence artificielle dominera le monde ». Dans le contexte mondial actuel, je laisse le lecteur juge de l’efficacité future des diverses réglementations et législations qui vont émerger ici et là. Et, quand bien même il y aurait, in fine, une bien improbable harmonisation ; par analogie, si l’on revisite les armes interdites par le « droit de la guerre »… que dire ? Depuis 2010 elles ont atteint un niveau record.

Pendant que le législateur légifère, les acteurs concernés demeurent partagés devant ce nouvel Eldorado financier. Certains comme Sam Altman – cofondateur avec Elon Musk de l’organisation à but lucratif plafonné OpenAI – « promettent » qu’ils ne franchiront pas le Rubicon. Sam Altman joue (selon moi) les lanceurs d’alertes dans la mesure où, et c’est là mon interprétation, le but de Sam Altman est de participer à l’élaboration de règles qui lui seront favorables et lui permettront de mettre de nombreuses barrières à l’entrée d’éventuels concurrents. Pour le reste la promotion mondiale de Chat GPT et de Open AI aura été une immense réussite.Dans cette dynamique se présentant comme le rempart face aux dangers de l’IA, ce dernier à même lancé un projet nommé Worldcoin dont il assez complexe de comprendre l’objet… une cryptomonnaie liant le scan de l’iris d’utilisateurs à une preuve d’humanité… et selon l’initiateur « de faire comprendre que ce n’est pas le diable ». Dont acte, c’est rassurant… cela n’est pas très probant jusqu’alors, depuis août « ces prestataires embauchés en ligne naviguent laborieusement de café en espace de coworking pour scanner les iris de curieux, » ces derniers ne rencontrent pas un franc succès. Certains médias parlant de ce projet en développement aux contours flous allant jusqu’à qualifier Sam Alman de « pompier pyromane de l’intelligence artificielle ! »

Certains chercheurs et observateurs plus réservés s’essayent d’avoir une vision anticipatrice et essayent eux aussi d’alerter… Tant sur l‘IA, qui avance a une vitesse fulgurante que sur des avancées de l’informatique quantique. Malheureusement dans ce débat ou l’argent aveugle les uns, tandis que le cynisme anime les autres, la phrase de Robert Anson Heinlein reste d’actualité : « Avoir raison trop tôt est socialement inacceptable ». Ainsi dans cette période percluse d’IA-Enthusiasts, ceux et celles qui se montrent plus réservés et expliquent les raisons pour lesquelles, il est urgent de urgent de comprendre, d’identifier et d’anticiper les impacts potentiels de ces technologies, de réguler, avant qu’ils ne soient trop tard, sont vite rangés dans la case des illuminés, des rétrogrades, des technophobes, voire de complotistes. Il est vrai qu’évoquer l’avènement de technologies hors contrôle qui pourrait destituer un jour l’humanité du choix de son destin est pour certains, par conviction, par méconnaissance, totalement inaudible. Pour ce qui me concerne je pense que nous sommes désormais engagés dans une spirale infernale qui, à moins d’un sursaut mondial qui demanderait une entente mondiale et qui ne s’arrêtera pas – un sursaut aussi improbable qu’inespéré – Ce nouvel Eldorado économiquement démesuré acceptera difficilement des limites et à terme à l’instar de la merveilleuse invention qu’a été Internet dans sa vocation originelle il pourrait être dévoyé à nos risques et périls.

IA : Une nouvelle ère pour la cybercriminalité.

Mais revenons en 2023, par-delà les bouleversements déjà initiés et en cours dans de multiples secteurs : Technologie de l’information et des communications (TIC), Enseignement; Santé; Automobile; Transport; Sécurité et défense; Finance, Industrie manufacturière; Commerce électronique et marketing; Énergie, Éducation… Il est une chose plus certaine que probable les cybercriminels amateurs comme les Black hat les plus aguerris réfléchissent depuis longtemps à un usage de l’IA pour performer leurs crimes et délits qualitativement et quantitativement. Nous entrons avec l’IA dans une nouvelle ère de la cybercriminalité.

Certaines cyberattaques utilisant l’IA ont déjà été identifiées, d’autres sont, au pire, peut-être déjà en cours, mais non encore connues, au moins mal, en gestation… ces attaques multiformes, je vais y revenir, seront évolutives au rythme des avancées de l’IA. Leur nombre sera considérable, leur puissance, la modélisation d’attaques adaptables au regard des réactions de la cible… ajoutons qu’il est probable que des néophytes puissent venir grossir le rang des cybercriminels aguerris puisque permettant à des « amateurs » de s’y risquer en pouvant coder avec des connaissances extrêmement basiques.

Les cyberattaques utilisant l’IA et/ou susceptibles d’y avoir recours.

Après avoir identifié une typologie d’attaques qui peuvent et/ou pourront s’appuyer sur L’IA, j’exposerai les défis qui attendent les entreprises et la vigilance dont devront faire preuve les utilisateurs. J’aborderai ensuite les approches de défenses possibles qui pourraient être mises en place pour anticiper les incidents – tout du moins pour les entreprises et organisations -. Certes l’utilisation de l’IA par les Black Hats et les escrocs « amateurs » n’est « officiellement » pas encore répandue, tout du moins non quantifiée. Pour autant, déjà en 2018 les analystes soupçonnaient une cyberattaque assistée par l’IA et le vol de données financières et personnelles chez TaskRabbit… une attaque furtive qui a compromis 3,75 millions d’utilisateurs. Cette montée en puissance progressive a été confirmée par une étude de 2020 menée par l’Agence suédoise de Défense et de Recherche . Cette étude qui date de deux ans avait permis d’une part de répertorier les types de cyberattaques qui pourraient s’appuyer sur l’IA, tout en indiquant les cyberattaques ayant déjà eu – et de façon certaine – recours à l’IA. Parmi celles-ci, on retrouve sans surprise le phishing, ou l’hameçonnage, à savoir se faire passer pour une entreprise, un organisme d’état et récupérer les données nécessaires pour arnaquer la victime. L’IA permettant des e-mails, des SMS de phishing de plus en plus sophistiqués et convaincants puisqu’en mesure d’analyser les habitudes et le mode de communication de la cible et de créer des messages extrêmement personnalisés.

Pour ceux et celles qui se pensent bien au-delà de cela, je leur conseille ce test : un test pré IA… Que celui qui fait un sans-faute se dénonce… imaginez avec l’utilisation de l’IA – outre la démultiplication des envois – le degré de sophistication qui pourra être atteint pour duper un usager, aussi averti soit-il !

La seconde cyberattaque avérée ayant utilisée l’IA : L’automatisation de saisie de Captcha (acronyme de l’anglais « Completely Automated Public Turing test to tell Computers and HumansApart ») une mesure de sécurité de type « authentification par question-réponse ». Une de ces attaques a été menée, selon les chercheurs de la société RiskIQ par un groupe de la mouvance blackhat « Magecart » contre Ticketmaster en 2018. (« Magekart » fait référence à plusieurs groupes de pirates qui utilisent des techniques de skimming, adaptée au web, à savoir des arnaques à la carte bancaire. Nonobstant les deux types d’attaques évoquées, la troisième cyberattaque, plus proche de l’arnaque est L’analyse des comportements des utilisateurs… une approche qui a été utilisée très tôt par certains sites de rencontre, en mesure de produire de faux profils et des dialogues de plus en plus élaborés, pour ne pas dire quasiment indétectables. Plus « amusant » encore, désormais même l’utilisateur qui se faisait duper hier par de faux profils peut duper les autres utilisateurs.

Si vous êtes à la recherche de l’âme sœur, que votre maîtrise de la langue et votre orthographe, votre culture, etc. vous semblent un peu défaillantes pour faire face à n’importe quel interlocuteur. En 2020 le site presse citron révélait que le programmeur belge Jeffrey Li avait imaginé un algorithme « entrainé » via google image, en capacité de valider automatiquement jusqu’à cent profils féminins susceptibles de plaire à son créateur, lui permettant – selon ses dires – d’obtenir cinq matches par semaine. La même année, le programmeur Robert Winters est passé à l’étape suivante en optimisant le bot (robot) développé par son compatriote : non seulement son bot était en mesure de swiper* (*geste de déplacement de son doigt sur l’écran tactile de son téléphone ou de sa tablette) automatiquement les profils en fonction de ses goûts, mais il était en mesure d’engager des conversations. Ce bot était également capable de démarrer une conversation basique avec les profils susceptibles de matcher. Comme l’a expliqué le programmeur DON Juan 2.0 à presse-citron “A un moment, le bot participait à environ 200 conversations en même temps. Je pense que Tinder a rapidement compris, et m’a banni, évidemment, de la plateforme” outre cette « anecdote » et les utilisations de l’IA à des fins délictuelles, voire douteuses (pour ne pas dire potache et un peu sexiste) » qui sont avérées. D’autres usages (sauf erreur ou omission) qui n’ont pas encore été démontrés et s’avèreront pour le moins nocifs sont à portés. Voilà ci-dessous les usages les plus probables qu’en feront les cybercriminels…

- Les Attaques de force brute améliorées afin d’aller plus vite et plus fort dans le « cassage » des mots de passe et des clés de chiffrements en alliant vitesse et sophistication. •

- Le développement de Malwares apprenants en mesure de s’adapter aux défenses de sécurités de leur cible pour les contourner.

- Les Attaques de déni de service augmentées ; si l’attaque de déni de service distribué (DDoS) demeure l’une des attaques les plus « basiques » visant à saturer un site de requêtes afin de le faire « tomber », la plupart des entreprises « sérieuses » sont à même de s’en prémunir, L’IA pourrait alors être utilisée pour mettre en place des attaques similaires, mais plus difficilement détectables de par leur sophistication et pouvant déjouer les contre-mesures en place en modifiant en temps réel les méthodes d’attaque en cours (cf. l’IA contre l’IA).

- La Falsification d’identité et la propagation démultipliée de fausses informations, ce n’est pas une bonne nouvelle pour internet, cependant nous pouvons craindre une production démultipliée de fausses informations passant d’une production artisanale (cf. les trolls de Saint-Pétersbourg) à une ère industrielle. L’IA est en mesure de faciliter la génération de Deep Fake abréviation de « Deep Learning » et « Fake », d’images truquées, d’enregistrements audio falsifiés rendues profondément crédible (cf. deep pour profondeur) par l’intelligence artificielle. Impliquant outre la pollution du web, la compromission de la réputation de victimes et/ou de tromper les victimes dans le cadre d’arnaques. Ces falsifications pourraient prendre d’autres formes, les attaques pourront cibler également les systèmes qui se fondent sur la reconnaissance vocale et faciale, il suffira de récupérer le matériel.

- Autre champ qui pourra être exploité le Social engineering perfectionné : travail de patience et d’observation de la cible hier avant de passer à l’attaque d’entreprise, l’IA facilitera la collecte de données pertinentes, permettant la mise en œuvre d’attaques des cibles plus rapides et surtout beaucoup plus pertinentes et convaincantes (cf. arnaque au président) pour ce qui concerne les particuliers, l’IA pourra permettre aux escrocs la création des profils sociaux factices très crédibles et plus efficaces pour manipuler leurs victimes et les inciter à divulguer des informations sensibles.

- L’Analyse de vulnérabilités automatisée : pour ce qui concerne les attaques zéro day, les blackhat hackers pourraient exploiter l’IA pour identifier plus rapidement et efficacement les vulnérabilités dans les systèmes informatiques, facilitant ainsi les attaques. Et si ce n’était que cela. Quand il n’y en a plus il y en a encore, pour ce qui est des contournements de sécurités l’IA est en mesure d’analyser et de comprendre les systèmes de détections des tentatives d’intrusions, elle sera donc en mesure d’apprendre en temps réels les modus vivendi de détection, et s’adaptera pour les contourner. Je vais m’en arrêter-là, les potentiels de mésusages sont innombrables. Il me faudrait encore évoquer le Cryptomining malveillant, les attaques ciblant les marchés financiers… n’en jetons plus…l’IA sera au service du bien comme au service du mal, mais alors que faire pour se préparer au mieux à la déferlante en approche ?

De l’IA offensive et l’IA défensive.

l’IA offensive en cours de structuration, les structures sont d’ores et déjà en train de développer une IA défensive. Il est bien évident que l’IA offensive, plus elle gagnera en puissance de feu et en sophistication, plus elle échappera à la compréhension de l’humain aussi talentueux soit-il. Au mieux il comprendra, mais trop tard, l’attaque subie. En temps réel, seule une IA défensive adaptée à l’attaque, sera capable de la détecter et de la bloquer. Dans ce nouveau combat dans le cyberespace qui oppose les blackhats et les entreprises et organisme, il convient que ces dernières soient conscientes de ces nouveaux risques et soit en mesure d’identifier ces risques augmentés, de mettre en place des solutions pour un combat de haut niveau d’un nouveau genre : une guerre d’algorithmes apprenants que ne renierait pas la série Black Miror ! l’IA défensive est le nouvel enjeu en termes de cybersécurité ! Elles se protégeront et ipso facto protègeront leurs clients. À contrario, il est évident que par-delà les professionnels et les secteurs d’activités qui ont compris la nécessité d’investir urgemment dans ce type l’IA défensive. Cette approche résiliente pourra passer par :

- De la formation sur les nouvelles menaces potentielles liées à l’IA et aux types cyberattaques à prévoir auprès des professionnels de la cybersécurité, à une sensibilisation forte sur la puissance augmentée des techniques d’ingénierie sociale et aux comportements suspects.

- L’acquisition d’outils évolutifs dédiés à ce type d’attaques.

- Une augmentation de la sécurité des réseaux des entreprises en le divisant en segment pas exemple, une façon à limiter la casse en cas de cyberattaques réussies.

- L’usage de pare-feu augmentés, des systèmes de détection d’intrusion augmentée, système qui agissent en temps réel dès qu’une attaque ou un comportement suspect et détecté Il s’agit de connaître finement le fonctionnement d’un réseau ou le comportement d’un utilisateur, pour réagir au plus vite en cas d’anomalie.

Pour résumer : L’une des branches les plus prometteuses de la cybersécurité à base d’IA est l’UEBA, définie par Gatner dès 2015, l’UEBA, à savoir ‘User and Entity Behavior Analytics’. Il offrait les mêmes capacités que l’approche « User Behavior Analytics » UBA* (précédemment recommandée) en ajoutant la possibilité de suivre l’activité d’entités non humaines, notamment les appareils, les applications et les serveurs. Une approche adaptée à l’IA « L’UEBA pour « User and Entity Behavior Analytics » est une technologie de cybersécurité innovante qui utilise des algorithmes d’apprentissage automatique afin de créer une base de référence concernant les comportements normaux des utilisateurs au sein de votre réseau ».

S’il n’est pas de solutions uniques pour contrer des attaques multiformes, je vous invite à découvrir ces entreprises qui fondent des solutions de cybersécurité, pour contrer différentes formes d’attaques en utilisant l’IA. Il s’agira alors pour les acteurs en front line de choisir l’entreprise, voire les entreprises partenaires qui répondront au plus près au type de risques auxquels leur entreprise est exposée, voilà ci-dessous quelques exemples de prestataires combattant l’IA avec… l’IA :

CrowdStrike utilise un système basé sur l’IA qui analyse le comportement des utilisateurs pour optimiser la détection des menaces.

Trellix propose une solution de sécurité évolutive apprend et s’adapte grâce à l’apprentissage automatique et à l’intelligence artificielle.

Check Point« Utilise l’IA et le deep learning pour fournir une prévention avancée contre les exploits du système de noms de domaine (DNS) et le phishing, ainsi qu’une sécurité autonome de l’IoT ». Ce ne sont là que quelques exemples, d’autres entreprises sont d’ores et déjà dans cette dynamique. Vectra AI, Cynet, Sophos… qui sont très avancés… et que je vous laisse découvrir.

Comme se préparer aux attaques IA à venir…

H pour humilité ; P pour partenaires; F pour formation; P pour partage.

L’Humilité sera nécessaire pour les professionnels de la sécurité. Leur mission sera d’identifier les Partenaires pertinents et d’augmenter de fait et au plus rapidement leurs compétences en IA, de travailler main dans la main avec ces derniers. Les nouvelles compétences acquises leur permettront de renforcer les Formations et la sensibilisation des salariés, qui sont qu’ils le veuillent ou non des partenaires cruciaux de la cybersécurité d’une structure… Si le protocole d’IA défensive pourra être élaboré avec le ou les prestataires choisis afin que l’équipe sache comment réagir en cas d’incident, les basiques n’en demeurent pas moins toujours d’actualité :

Pour les personnes en charge de la cybersécurité en interne il leur faudra continuer à veiller à ce que les applications et les systèmes d’exploitation de leur entreprise soient toujours dotés des derniers correctifs; utiliser le chiffrement pour protéger les données sensibles pendant le stockage et la transmission. Il peut être aussi judicieux d’avoir – selon la classification de la structure – d’avoir recours à des hackers éthiques testant les systèmes régulièrement, cela peut être investissement pertinent. Enfin, la notion de Partage va s’avérer primordiale. Bien que les entreprises soient peut encline à faire connaitre un incident pour des raisons naturelles d’image, ce frein doit plus que jamais être levé. Il est impérieux que les entreprises puissent collaborer se transmettre les informations afin d’apprendre collectivement et faire face en bloc…chaque expérience partagée concernant des attaques nouvelles impliquant l’IA sera précieuse… pour améliorer les protocoles de tous.

« Avoir raison trop tôt est socialement inacceptable » – Robert Anson Heinlein

Photo credit: robpegoraro on VisualHunt

Vous avez aimé cet article ? Likez Forbes sur Facebook

Newsletter quotidienne Forbes

Recevez chaque matin l’essentiel de l’actualité business et entrepreneuriat.

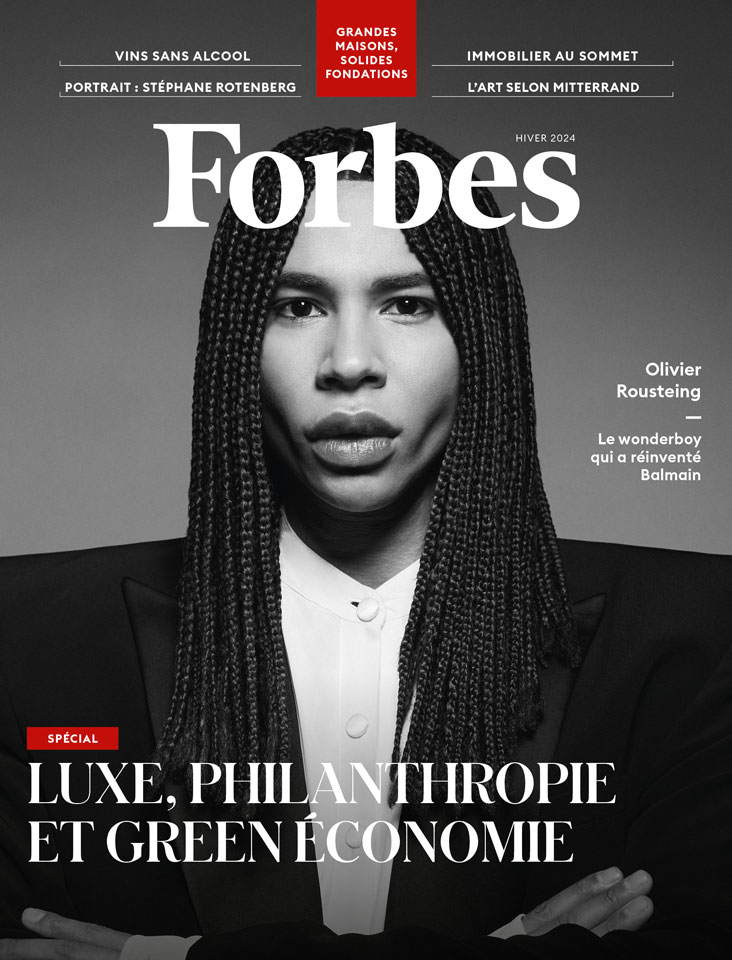

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits