Google affirme avoir récemment atteint la “suprématie quantique“, qui signerait l’obsolescence prochaine de tous les systèmes de cryptographie actuels. C’est factuellement et mathématiquement faux. Derrière le sensationnalisme médiatique, voici un résumé de la réalité des faits, tout aussi passionnante.

Les faits ne sont pas des opinions, et inversement. C’est encore plus vrai lorsqu’on s’exprime dans le champ scientifique. Le matraquage marketing des deux principaux mastodontes américains engagés dans la course à la suprématie quantique, à savoir IBM et Google, auquel s’ajoute la pression des chinois (annonçant récemment l’ouverture pour 2020 d’un centre de recherche sur le sujet, qui sera doté de 10 milliards de dollars), multiplié par l’incompétence scientifique patente d’une majorité des journalistes sévissant dans la tech : tout cela a abouti récemment à un grand nombre d’articles proclamant la fin prochaine de la Blockchain, des crypto-monnaies, et de la cryptographie en général. C’est du grand n’importe quoi.

On en arrive ainsi à des articles du genre “Comment un ordinateur quantique a cassé le protocole RSA 2048 Bits en 8 heures” générant 408 000 résultats sur Google Search, et qui décrit un algorithme qui n’a jamais tourné, conçu pour un ordinateur qui n’existe pas, basé sur un processeur quantique hypothétique à 20 millions de Qubits. Vous apprécierez rapidement avec les lignes qui suivent le ridicule et surtout l’inutilité, à date, d’une telle affirmation.

Il faut dire que l’avantage scientifique et stratégique absolument majeur qui serait conféré à la nation qui produirait le premier “véritable” ordinateur quantique a de quoi échauffer les esprits, et on tient clairement ici le digne successeur de la course à la Lune. Ce n’est d’ailleurs pas un hasard si la Nasa est directement impliquée dans la récente annonce sensationnelle de Google.

Comme à l’accoutumée, les investisseurs que je conseille m’ont logiquement demandé de leur résumer “en mode Golden Retriever” les tenants et aboutissant de cette composante majeure de la 4ème révolution industrielle, et ses potentielles implications sur la Blockchain et les cryptos-monnaies et je suis heureux de partager quelques extraits de ce travail avec vous.

Physique quantique

Conceptualisé par le prix Nobel 1965 de Physique Richard Feynmann à partie des années 50, l’ordinateur quantique repose comme son nom l’indique sur la théorie de la physique quantique affirmant qu’en deça d’une certaine échelle, la matière se comporte comme la lumière, tantôt comme une onde, tantôt comme un corpuscule. Cette dualité d’état induit des phénomènes totalement contre-intuitifs par rapport à la perception que nous avons du réel à notre échelle physique, mais elle est d’autant plus difficile à appréhender qu’elle disparaît dès qu’on tente de l’observer directement : à la moindre mesure, une particule perd sa fonction d’onde en “superposition”, et redevient un corpuscule “classique”, caractérisé cette fois par une position dans l’espace précise (entre autres caractéristiques, dont le spin).

Je ne m’étendrai pas sur les-dits phénomènes, dont la seule description prendrait plusieurs dizaines de pages : je vous invite à lire les articles brillants (et l’eBook de 500 pages) d’Olivier Ezratty, qui est sans aucun doute le meilleur vulgarisateur sur le sujet. Sachez seulement qu’il est notamment question de superposition d’état, de décohérence, d’intrication et de non-localité. En exploitant ces capacités étonnantes de la matière à très petite échelle, il devient possible d’imaginer une informatique totalement inédite, ouvrant la voie à une manière de raisonner et de calculer inédite, et surtout infiniment plus performante…

Informatique quantique

L’informatique traditionnelle repose sur le concept de registres de “Bits” (contraction de “binary digit”), chaque “Bit” pouvant adopter une parmi deux valeurs possibles (0 ou 1), comme un interrupteur. Un algorithme est une série d’opérations effectuées sur les Bits composant un registre déterminé, et le résultat est obtenu par la lecture du registre ainsi modifié. En terme d’informations, un registre de N Bits va pouvoir stocker au moment où lui seront appliqués les calculs de l’algorithme une seule parmi les 2N combinaisons de valeurs 0 ou 1 possibles pour les Bits qui le composent.

En informatique quantique, on va travailler à partie de registres de “QuBits” (contraction de “quantum binary digit”), chaque “QuBit” adoptant simultanément la valeur 0 et la valeur 1 lorsqu’il est en état de superposition. En terme d’informations, un registre de N Qubits en parfaite cohérence va donc pouvoir stocker, au moment où lui seront appliqués les calculs de l’algorithme, 2N combinaisons de valeurs 0 ou 1 possibles pour les Qubits qui le composent. Une limite importante fait toutefois que cette capacité de calcul massivement parallèle reste cantonnée à des algorithmes très spécifiques : les Qubits perdant leur cohérence lors de la lecture du registre de sortie, celui-ci ne fournit qu’une valeur parmi 2N.

Une puce quantique à 100 Qubits en cohérence maîtrisée pourra ainsi traiter simultanément… autant d’informations qu’il existe de particules composant notre planète. Parvenir à créer une Q-Chips à 300 Qubits en cohérence parfaitement maîtrisée permettrait de manipuler autant d’informations unitaires qu’il existe de particules… dans l’univers.

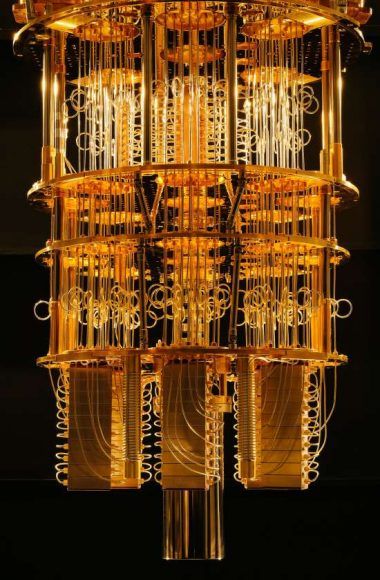

Refroidisseur calorique de l’ordinateur quantique IBM – IBM RESEARCH – Flickr (Licence gratuite- Crédit: Graham Carlow)

Applications concrètes

Richard Feynmann a parfaitement résumé le potentiel d’une telle puissance de calcul : “la nature est quantique, il faut la calculer avec un ordinateur quantique.” En d’autres termes, l’algorithmique quantique permettrait de modéliser la matière, le réel et les innombrables interactions qui les caractérisent de manière infiniment plus efficace qu’avec les meilleurs supercalculateurs actuels. Il deviendrait alors possible de “calculer” les molécules et agrégats de molécules les plus efficaces dans tous les domaines, alors que nous progressons essentiellement à l’heure actuelle de manière quasi empirique. Un supercalculteur quantique pourrait ainsi déterminer une fois pour toute la composition de la cellule photovoltaïque, du médicament, ou de l’engrais le plus efficace matériellement concevable (“efficace” étant ici une combinaison de facteurs comme le coût, le temps et les process de production, la tenue dans le temps, le rendement énergétique, etc). Inutile de mentionner ce qui serait possible en terme d’armement…

On comprend ici que l’utilisation de l’algorithmique quantique pour “casser” des clés cryptographiques est donc totalement insignifiante à côté des autres applications possibles. Mais la fixation des médias sur cette possibilité tient au fait que le premier exemple concret d’algorithme “quantique”, c’est à dire spécifiquement pensé pour performer sur un ordinateur quantique, l’algorithme de Schor, repose sur la décomposition d’un nombre en facteurs premiers, qui est une des bases d’un certain type de chiffrement cryptographique utilisée notamment dans les transactions entre utilisateurs d’un coin opérant à partir d’une Blockchain. Mais j’y reviendrais un peu plus loin dans cet article.

Inutile de s’enflammer toutefois : la puce Sycamore développée par Google pour réaliser son “exploit quantique” récent est totalement incapable d’exécuter un tel algorithme : elle affiche une profondeur maximale de 20 portes quantiques, inférieure de plusieurs ordres de grandeurs à ce qui serait nécessaire pour un tel calcul.

La suprématie quantique selon Google

Que s’est-il donc passé ces derniers jours qui a donné tant d’exclamations hystériques sur la fin prochaine des crypto-monnaies et de la blockchain grâce à l’exploit quantique de Google ?

Tout arrive par un communiqué de presse publié en août sur le site de la Nasa puis retiré car incomplet et pas encore relu, qui ré-apparaîtra dans sa version finale assumée cette fois par tous les partenaires de l’expérience (Nasa, Oak Ridge National Laboratory et Google) le 23 octobre.

Ce communiqué fait référence à une recherche détaillée dans un article signé par environ 80 personnes, envoyé à la revue Nature le 22 juillet 2019, accepté par le comité de rédaction le 20 septembre, publié le 23 octobre et intitulé “Quantum supremacy using a programmable superconducting processor”, dans lequel il est expliqué qu’une l’équipe de chercheurs est parvenue à faire fonctionner un processeur à 53 Qubits (le Sycamore) en cohérence sur un calcul test spécifique amenant à trois conclusions précises :

- Le calcul a été complété correctement par un processeur quantique à 53 Qubits en cohérence “parfaite”

- Le temps de calcul nécessaire pour compléter le calcul fut d’environ 200 secondes

- Le même calcul réalisé sur un supercalculateur classique nécessiterait 10 000 ans

Pour la petite histoire, et afin de vous permettre de ne pas être induit en erreur sur les prochaines communications scientifiques que vous pourrez être amené à lire, les 53 Qubits en cohérence atteints par Google ne peuvent être comparés aux Qubits de type “recuit simulé quantique” de la société canadienne D-Wave : alors que les 53 Qubits de la puce Sycamore sont dédiés au calcul (Qubit logiques = Qubits physiques), il faut environ 1000 Qubits physiques D-Wave pour simuler un Qubit logique. D’un laboratoire à l’autre, un même terme ne désigne donc pas exactement le même concept, la confusion étant entretenue au service d’un discours marketing axé sur la prochaine levée de fonds ($177 millions levés jusqu’ici pour D-Wave par exemple). Et on qualifie les crypto-actifs de sulfureux…

On parle de suprématie quantique pour l’ordinateur quantique qui serait capable de réaliser correctement un calcul inaccessible au meilleur des supercalculteurs “classiques” actuels. Google affirme donc être parvenu à un tel résultat, les 10 000 ans nécessaires à un supercalcuteur classique pour réaliser son calcul pouvant être considérés comme inaccessibles.

Las, dès le 21 octobre, dans un article titré “On ‘Quantum Spremacy’“, le concurrent IBM, mais également plusieurs autres experts indépendants revoient ce chiffre un poil à la baisse : un supercalculateur classique soit-disant “dépassé” parviendrait en fait à boucler le calcul en 2,5 jours tout au plus. Cela reste quand même 1080 fois plus lent qu’avec le Sycamore de Google, mais permet de relativiser la performance. Et surtout, d’affirmer qu’on n’a donc pas encore véritablement atteint la fameuse “suprématie quantique”.

L’exploit de Google est remarquable en ce qu’il constitue indéniablement une avancée technique dans son secteur, mais il est très, très loin de toute autre constat qu’une preuve de concept sur un calcul hyper spécifique avec un processeur encore largement trop limité (puissance, complexité de mise en œuvre, aucun industrialisation démontrée) pour permettre tout espèce d’application industrielle majeure.

La cryptographie est-elle en danger ?

Simplement : non, mais entrons un peu dans le détail… On distingue trois grandes familles d’algorithmes cryptographiques :

- Les fonctions de hashage

- La cryptographie asymétrique (dite à clé publique)

- La cryptographie symétrique (dite à clé privée)

Toutes ne sont pas utilisées dans le paradigme des crypto-monnaies et de la Blockchain. Certaines architectures utilisent des formats hybrides (association de cryptographie symétrique et asymétrique).

Les fonctions de hashage sont utilisées pour vérifier l’intégrité d’un fichier ou de certificats électroniques sans avoir besoin de travailler sur les documents eux-même, mais sur un “hash” qui leur est spécifique et de taille paramétrable. Elles reposent mathématiquement sur les effets d’avalanche. Les algorithmes de hashage les plus connus sont MD5 et surtout son successeur SHA-256, utilisé dans le cas de la Blockchain Bitcoin par les mineurs qui tentent de résoudre la “difficulté” d’un bloc en parvenant à trouver en premier le “Nonce” à inclure dans ce bloc pour que le résultat de son hash commence par la suite hexadécimale attendue par la Blockchain afin de proclamer la validation du bloc. Selon toutes les études et simulations menées sur le sujet, ils ne semblent pas devoir être remis en question par un algorithme quantique ni à court ni à moyen terme.

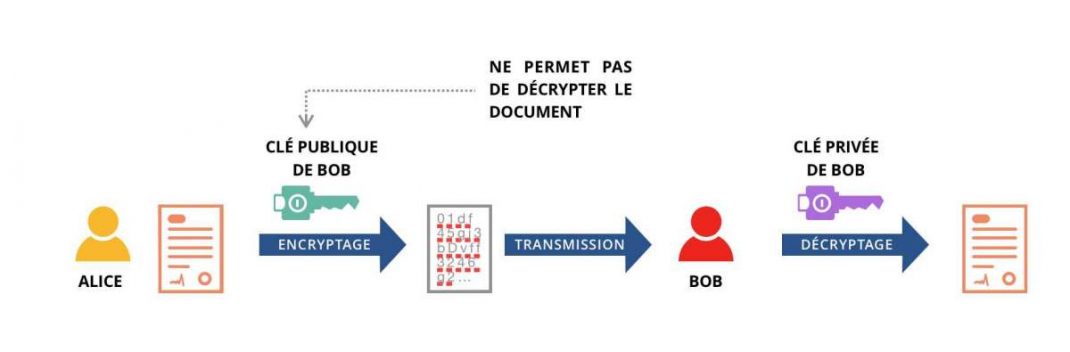

Schéma simplifié de la cryptographie asymétrique (F.Bonelli – The Crypto MBA):

La cryptographie asymétrique (ou à clé publique) est utilisée pour établir un canal chiffré entre deux parties, pour l’authentification ou encore la signature électronique. Elle est généralement basée sur les problèmes de factorisation d’entiers ou de logarithme discret, qui peuvent être cassés efficacement avec un algorithme quantique de type Shor en un temps plusieurs milliers de fois inférieur à ce qui serait nécessaire avec un algorithme dit “classique” (de type “crible du corps de nombres généralisé” GNFS-General number field sieve).

Dans les crypto-monnaies, ce type de cryptographie apparaît lors des transactions entre portefeuilles (“wallets”), faisant intervenir les clés publiques entre utilisateurs, qui utilisent ensuite chacun leur clé privée pour valider la transaction. La signature digitale est également utilisée pour la validation de transactions offline et dans le cas de contrats et portefeuilles multi-signatures.

La cryptographie symétrique est la famille d’algorithmes cryptographiques la plus menacée par l’informatique quantique. Concrètement, Peter Shor a démontré avec son algorithme quantique la possibilité de “rétro-calculer” assez efficacement la clé privée dérivant d’une clé publique. Les clés privées étant accessible lors de la soumission d’une transaction sur le réseau, il serait possible de modifier la transaction à son profit en ayant “cracké” la clé privée avant validation de la transaction dans un block de la Blockchain.

C’est le standard ECDSA (Elliptic Curve Digital Signature Algorithm, ou “algorithme de signature numérique à courbe elliptique”), dérivé de l’ECC (Elliptic-curve cryptography, ou “cryptographie à courbe elliptique”), sur lequel reposent aujourd’hui la plupart des dispositif de cryptage asymétrique utilisés dans les crypto-monnaies. Il a été préféré pour des raisons de taille de clé inférieure au standard RSA encore utilisé par exemple dans certains certificats SSL sur le web. Contrairement au RSA, qui dépend de la difficulté de factoriser un grand nombre entier, ECDSA s’appuie sur la difficulté de calculer le «logarithme» discret d’un grand nombre entier, c’est à dire, connaissant a = bn , comment retrouver n, le logarithme de a en base b. RSA peut-être cassé directement par un algo Shor tandis qu’ECDSA nécessite un algo Shor modifié.

Mais ce n’est pas pour demain : une clé ECDSA de 256 bits (celle utilisée avec dans le cas de la Blockchain du Bitcoin, offrant pour info une sécurité comparable à une clé RSA de 3072 bits) nécessiterait la puissance d’un quantum processeur de 2330 Qubits en cohérence et 126 milliards de portes quantiques de type Tofolli pour être “cassée”. On est loin du Sycamore de Google et de ses 53 Qubits en cohérence avec 20 portes quantiques…

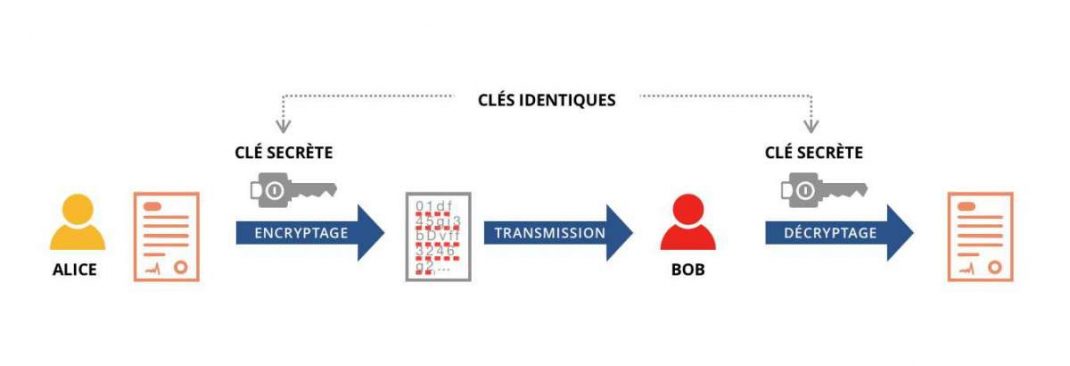

Schéma simplifié de la cryptographie symétrique (F.Bonelli – The Crypto MBA):

La cryptographie symétrique (ou à clé secrète) est utilisée pour chiffrer efficacement des données, notamment lorsqu’un canal chiffré a été établi au préalable par des algorithmes asymétriques . Elle est basée sur les principes de diffusion et de confusion. En informatique quantique, l’algorithme de Grover permettrait d’accélérer la recherche d’une clé de chiffrement symétrique, mais sans pour autant remettre en cause les principes de la cryptographie à clé secrète car il suffit d’augmenter la taille des clés de chiffrement pour garder une avance confortable en terme de sécurité : une clé de AES 256 bits nécessiterait ainsi 2 953 Qubits cohérents pour être cassée. Je me répète, mais Google en est donc péniblement à 53, sachant que la difficulté à maintenir la cohérence augmente exponentiellement avec le nombre de Qubits…

La cryptographie symétrique est limitée par le risque pris dans la distribution de la clé secrète dans le cas d’une interaction entre un grand nombre de participants mais elle est mathématiquement plus efficace que la cryptographie asymétrique : dans le cryptage asymétrique, la relation mathématique entre une clé publique et la clé privée associée implique le risque d’un “cassage” par des attaquants pour déchiffrer le cryptage, les clés asymétriques se doivent donc d’être beaucoup plus longues pour présenter un niveau de sécurité équivalent.

Schéma simplifié des algorithmes cryptographiques impliqués dans la Blockchain Bitcoin (F.Bonelli – The Crypto MBA):

Les crypto-monnaies sont-elles en danger ?

Comme nous venons de le voir, les algorithmes de chiffrement cryptographiques sur lesquels reposent les crypto-monnaies et le Blockchain ne sont pas encore menacés, et il faudra un certain temps avant qu’un ordinateur quantique soit mis au point qui soit capable de les “casser” efficacement (i.e. avec un coût global inférieur au gain espéré une fois le “hack” réussi). D’autant qu’il sera possible d’ici là de les faire évoluer.

Mais il existe en revanche une faille, qui pourrait être conséquente : il s’agit des adresses, et donc des paires de clés publiques faisant référence à des “paquets” de coins dont les propriétaires sont morts ou ont perdu les clés privées correspondantes. Ces clés, n’étant pas mises à jour, seront les plus vulnérables à un cassage par quantum computing. Or dans le cas du Bitcoin, le seul “paquet” de Bitcoin appartenant au disparu Satoshi Nakamoto, et qui n’a jamais “bougé” depuis la création de la crypto-monnaie, s’élève selon les estimations à… 980 000 Bitcoins, soit potentiellement 4,6% du total de la crypto-monnaie : largement de quoi déstabiliser les cours, pour dire le moins.

Comme le résume Andreas M. Antonopoulos : “vous saurez que l’ordinateur quantique existe pour de bon le jour où vous commencerez à constater que les Bitcoins de Satoshi ont changé d’adresse…”

Le système bancaire classique est-il en danger ?

Voilà une question que bizarrement peu de gens ont posée car, s’il s’avère que la Blockchain, structurellement conçue autour du chiffrage cryptographique à tous les niveaux de son fonctionnement, venait à être mise en défaut par l’algorithmique quantique, que penser alors des structures et process utilisés par le système bancaire traditionnel ?

Combien de temps pensez-vous qu’il faudra à un ordinateur quantique pour casser les clés CVC1 (piste magnétique) et CVC2 (gravées) d’une carte de crédit ? Ou pour pénétrer un réseau de transactions bancaires et faire valider une “fausse” transaction ?

Vous trouverez bien peu d’études sur le sujet, et pour cause. Il est plus facile de fixer l’attention sur la paille dans l’œil des crypto-monnaies que de sortir du déni entretenu sur la poutre présente dans celui des structures bancaires actuelles…

Dans le même ordre d’idée, vous avez compris que si la NSA possédait ou arrivait un jour à posséder un ordinateur quantique capable de casser les clés cryptographiques utilisées par les crypto-monnaies et la blockchain, elle pourrait également s’attaquer à la totalité des communications encryptées utilisées dans tous les autres domaines : codes nucléaires et tous types de lanceurs d’engins, communications militaires de tous pays, communications scientifiques et industrielles (secrets de fabrication et brevets…), etc.

En clair, elle aurait sans doute envie de fouetter d’autres chats que le Bitcoin…

Solutions post-quantiques

Exactement comme dans le cycle perpétuel des dispositifs radars et anti-radar, missiles et anti-missiles, les algorithmes cryptographiques ont régulièrement évolué au fil du temps, et de l’évolution des algorithmes de “cassage” qui leur étaient opposés. L’arrivée potentielle du quantum computing n’y changera absolument rien : face aux chercheurs de Google, IBM, et consors qui travaillent à l’élaboration de processeurs intégrant un nombre croissant de Qubits en cohérence, d’autres experts travaillent de leur côté à l’élaboration d’algorithmes cryptographiques résistants aux attaques de type quantique (on les appelle “Post-Quantiques“).

Si l’informatique quantique tient ses promesses, le changement de civilisation qu’elle entraînerait serait d’une telle magnitude que la question de la cryptographie deviendrait franchement très, très accessoire.

Winter is coming ?…

C’est l’expression à la mode dans la Silicon Valley lorsqu’un rush d’investissements dans un secteur précis commence à se tarir au fil de la prise de conscience par les investisseurs que le secteur prometteur un moment privilégié ne semble finalement pas prêt de générer le ROI tant espéré avant plusieurs décennies au minimum. Dernier secteur victime de l’ “Investment Winter” : l’Intelligence artificielle. Exactement comme avec le quantum computing, et selon un schéma bien rôdé, il aura suffit de quelques annonces tonitruantes sur une victoire contre un grand maître d’échec ou de Go, une bonne com. d’IBM sur son programme Watson, quelques robots humanoïdes qui parlent d’éradiquer les humains, et quelques pitchs inspirés sur le mode “fake it till you make it” de start-up US pour que les VCs frétillent du chéquier. Mais au final, les applications industrielles vraiment révolutionnaires se font attendre, et on s’aperçoit que les système experts “classiques” possèdent encore une bonne marge de progression en terme d’efficacité tandis que nombre de travaux faisant appel au fameux “machine learning” restent encore au stade de la recherche pure.

Un autre exemple d’ “Investment Winter” ? La supraconduction à haute température…

En 2017 et 2018, les investissements privés sur le quantum computing ont dépassé selon un récent article du magazine Nature les 450 millions de $, soit plus de 4 fois le montant des deux années précédentes. Mais la majeure partie de cet argent est revenu à des compagnies axées sur le développement de “logiciels quantiques”, destinés à tourner sur des machines qui n’existent pas encore… La Chine est en pointe sur le sujet avec plus de 600 brevets déposés depuis 2012, devant les États-Unis (400), le Japon (150), et le Canada (80).

La Chine, encore elle, est également en pointe en matière de subventions publiques, avec plus de 10 milliards de $ annoncés pour un ” Chinese National Laboratory for Quantum Information Sciences”, loin devant les USA (avec la US National Quantum Initiative et ses 1,2 milliard de $), et l’Europe (avec le Quantum Flasgship et ses 1,1 milliard de $ étalés sur 10 ans).

En attendant la vraie disruption technologique d’une architecture de Qubits en cohérence évolutive (i.e. “scalable”), les axes de recherche actuels portent sur la définition d’une algorithmique capable de tirer parti des processeurs en dizaines de Qubits en cohérence disponibles actuellement, et l’optimisation du taux d’erreur dû principalement à la difficulté de maintenir cohérence et intrication entre Qubits.

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits