Ces dernières années, le deeplearning, technique utilisée dans l’Intelligence Artificielle, a montré des prouesses dans divers domaines d’application dans la santé, la robotique, la sécurité ou la bioinformatique. Cependant, celui-ci fait peur. En effet, il a aussi montré des capacités à manipuler facilement des données aussi bien visuelles qu’auditives en produisant des deepfakes suffisamment réalistes. Que sont les deepfakes ? Peuvent-ils être vus comme une menace uniquement ? Quelles mesures peuvent être prises pour les limiter ?

Qu’est-ce que le DeepFake ?

Le terme DeepFake peut être découpé, en anglais, en deux mots « deep » pour « profond » en français et « fake » pour « faux ». Il en découle ainsi deux caractéristiques :

- Le premier concerne la qualité du média résultant issu d’une manipulation logicielle qui est tellement réaliste que les modifications apportées sont imperceptibles à l’œil et l’oreille humaine.

- Le second est lié à la technologie utilisée. L’hypertrucage est basée sur des méthodes de deeplearning, notamment des GANs et des autoencoders.

Le deepfake ne consiste pas uniquement à du face swap (échange de visages) comme couramment évoqué. Dans l’image ou la vidéo, quatre niveaux de manipulation se concentrant sur le visage sont identifiables :

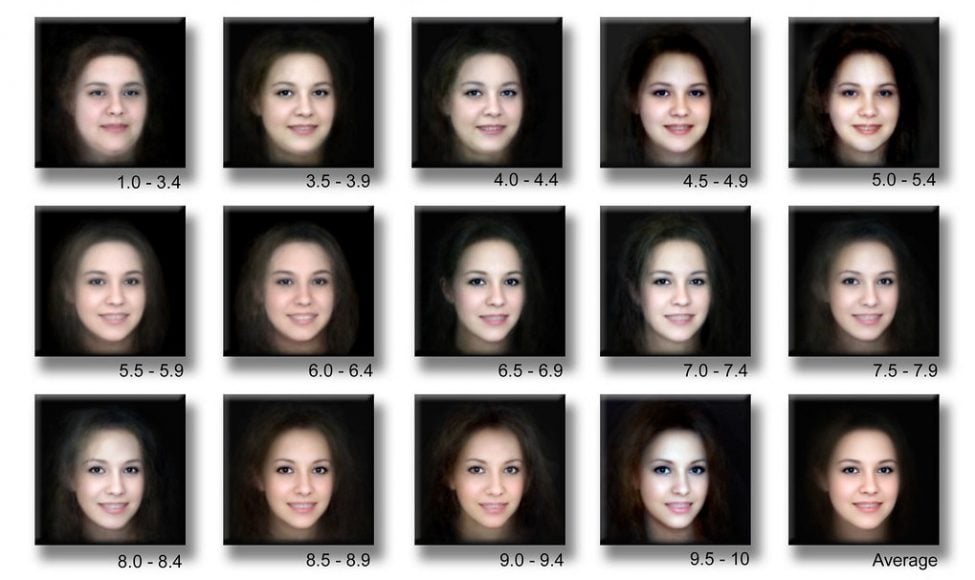

- La synthèse du visage : un faux visage est créé synthétiquement (fig1)

- La modification de ses caractéristiques morphologiques (cheveux, yeux, maquillage, …) (fig2)

- La modification des expressions faciales (fig3)

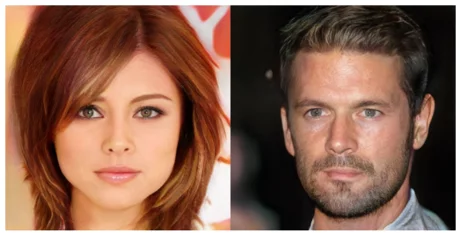

- Le face swap ou échange de visages (fig4)

Dans l’audio, on pourrait relever les mêmes niveaux de manipulations : la synthèse de voix, la modification de son expressivité et l’échange de voix.

fig1 : Synthèse de visage

fig1 : Synthèse de visage

fig2 : Modification des attributs du visage

fig2 : Modification des attributs du visage

fig3 : Modification des expressions du visage

fig4 : Échange de visages

Impact sociétal

Les craintes liées à la retouche d’images, de vidéos ou d’audios ne sont pas nouvelles. Celles-ci existaient déjà avec des logiciels tels que Photoshop ou After Effects. Celles-ci sont plus exacerbées pour le deepfake avec :

- La facilité d’utilisation des plateformes permettant de les créer.

- Le libre accès à ces algorithmes.

- Leur vitesse de production et de diffusion sur les réseaux sociaux.

- Leur hyperréalisme parfois imperceptible au sens de l’utilisateur (à l’œil du spectateur ou à l’oreille de l’auditeur).

- La quantité astronomique des données personnelles (photos, vidéos, audios) disponibles sur diverses plateformes (instagram, facebook, youtube).

Entre les mains d’acteurs mal intentionnés, ces outils peuvent influer négativement sur la réputation d’une personne (comme c’est le cas avec les face swap porno avec des visages de célébrités) ou la crédibilité des acteurs publiques d’une société (comme l’alertait Jordan Peele en diffusant une vidéo de l’ancien Président Barack Obama ayant des propos injurieux sur son successeur). Ceux-ci peuvent produire des montages montrant des agissements ou des dires qui ne se sont jamais réellement passés et qui sont en contradiction avec les idées de la personne représentées. Sans parler de l’impact psychologique de ces trucages sur les personnes victimes, cela poserait aussi un souci quant à la fiabilité des médias qui sont souvent utilisés comme preuves dans des procès ou pour des journalistes. Dans un monde où certaines démarches peuvent être effectuées en ligne comme l’ouverture d’un compte en banque, ces outils pourraient également faciliter l’usurpation d’identité.

Malgré les risques, ceux-ci peuvent avoir un impact positif, par exemple, dans l’éducation, la santé ou l’art. En effet, dans l’éducation, il serait possible de créer facilement des contenus dont les interlocuteurs représenteraient des personnages historiques afin d’attiser plus d’intérêt de la part des jeunes générations. Dans le cinéma, la production de films à faible coût, la reconstruction de certaines scènes avec des personnages d’un film décédés au court du tournage ou des traductions réalistes et synchronisées seraient possibles. Dans la santé, l’inclusion de certaines personnes handicapées, victime de SLA (sclérose latérale amyotrophique), par exemple, pourrait être effective en proposant des services leur permettant de reconstruire leur voix de façon plus réaliste et plus fluide.

Afin de limiter la mauvaise utilisation des deepfakes sur les réseaux sociaux, Facebook, Amazon, Microsoft, Partnership on AI et des académiques ont mis en place dernièrement un challenge mettant en compétition différents scientifiques, afin de détecter automatiquement des deepfakes. Cependant, il est probable que nous n’arrivions pas à identifier tous les deepfakes de façon certaine, il faudrait alors non seulement responsabiliser les internautes et les plateformes de diffusion afin de ne pas relayer des fausses données mais également offrir des services de certification des contenus audios ou vidéos.

Article écrit par Alia Rukubayihunga, Data Scientist

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits