Si l’on en croit la loi de Moore, la vitesse et la capacité des ordinateurs doublent tous les deux ans. En termes économiques, cela signifie qu’avec le même investissement, votre capacité de calcul double environ tous les 18 à 24 mois.

Mais à l’ère de l’IA, la loi de Moore peut aussi très vite devenir obsolète. En effet, avec la technologie du « Machine Learning », les capacités de calcul pourraient être multipliées par 16 au cours des deux prochaines années.

L’IA va vite.

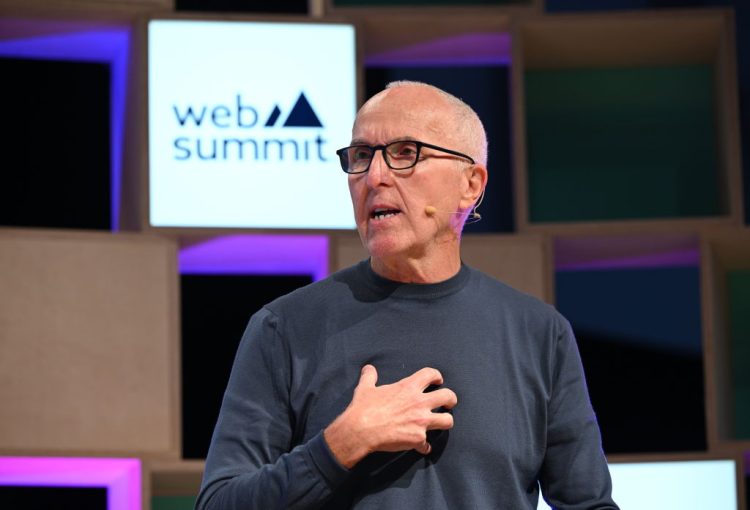

À la lumière de ces progrès, Dave Wright Chief Innovation Officer de ServiceNow interroge Nicolas Chapados, Vice-Président de la recherche chez ServiceNow sur les tendances actuelles en matière de modélisation du langage et de génération d’images basées sur l’IA avant qu’elles ne soient à leur tour devenues obsolètes.

Dave Wright : Votre équipe et vous-même êtes à la pointe des tendances. Vous suivez et analysez toute l’actualité technologique et les dernières études rendues sur ce sujet. En ce moment, nous entendons beaucoup parler de GPT-3 (Generative Pre-trained Transformer 3) qui est le plus gros modèle de langage. Pouvez-vous nous éclairer sur ce que signifie « gros modèle de langage » ?

Nicolas Chapados : En termes simples, un modèle de langage comme GPT-3 est un modèle statistique dans lequel les mots se suivent dans la même langue, comme l’anglais ou le français. Par exemple, le mot « service » est susceptible d’être suivi de mots comme « agent » et « livraison », mais pas d’un mot comme « cactus ». Ces modèles de langage existent depuis longtemps. Ils sont basés sur la compréhension de groupes de mots. On les retrouve dans de nombreuses applications, dans les moteurs de reconnaissance vocale, dans la traduction automatique, etc.

Ces dernières années, la modélisation du langage naturel a suscité un grand intérêt auprès de la communauté des chercheurs en IA. Par conséquent, une grande partie des ressources, au niveau mondial, a été investie pour faire progresser ses capacités. Cela s’explique par le fait que le traitement du langage naturel est la composante de base de toutes les applications de reconnaissance vocale, de traitement de texte, de traduction et de résumé de documents.

Les chercheurs se sont aussi interrogés sur l’intérêt d’amplifier les modèles et de passer plus de temps à les préparer. Cela leur a permis de réaliser que mieux entrainer un plus grand modèle lui donnera une meilleure compréhension du langage naturel. Cet entraînement lui permet d’obtenir plus de propositions avec des résultats plus précis, par exemple pour un moteur de recherche à reconnaissance vocale.

Dave Wright : Quels ont été les changements qu’a apportés le GPT-3 ? Était-ce seulement le volume de données nécessaires à l’entrainer qui ont été modifiées ou est-ce que cela a modifié la technologie algorithmique et le traitement des données ?

Nicolas Chapados : Ce qui est surprenant, c’est que le passage de GPT-2 à GPT-3 n’a entraîné que peu de modifications dans l’algorithme. Il a juste été nécessaire d’augmenter la taille des modèles et les entraîner avec davantage de données. Par exemple, GPT-2 comptait environ 1,5 milliard de paramètres, tandis que GPT-3 en compte plus de 100 fois plus, soit 175 milliards de paramètres.

La quantité de données utilisées pour l’entraînement des modèles a augmenté en même temps que la taille des paramètres. D’énormes ressources informatiques ont été nécessaires, notamment des centaines de GPU (graphics processing unit) travaillant en parallèle pendant des mois. Mais au-delà des efforts déployés pour former ces modèles, ce qui est impressionnant, c’est de constater à quel point ce déploiement améliore le résultat et la fonctionnalité d’un modèle. Concrètement, c’est cela qui est la véritable différence entre GPT-2 et GPT-3.

Dave Wright : Concernant les fake news générées par l’IA. Est-ce que cette dernière peut les détecter alors qu’elle est elle-même à l’origine de ce type de news ?

Nicolas Chapados : La détection des fake news est un vaste débat. Il n’y a pas, pour l’instant, de solution efficace pour résoudre ce problème. Les modèles de langage antérieurs, comme GPT-2, pouvaient créer des phrases cohérentes sur quelques paragraphes, mais au fil du texte, la cohérence se dégradait. Aujourd’hui, grâce à des modèles plus complexes, le texte et les images restent cohérents. Il est donc de plus en plus difficile de savoir si un humain ou une machine est à l’origine d’un document écrit.

Même au vu d’autres modalités, comme les premiers modèles de génération d’images et leur capacité à générer des visages (sans parler des capacités actuelles de génération d’images avec des modèles tels que DALL-E 2), il est, depuis longtemps, difficile de faire la différence entre un contenu généré par l’homme et un contenu généré par l’IA.

Dave Wright : Que pensez-vous de cette nouvelle technologie ?

Nicolas Chapados : Le système DALL-E 2 est apparu récemment. Ce qu’il génère à partir d’un texte saisi est remarquable. Par exemple, les chercheurs ont demandé à DALL-E de créer une image avec les contraintes suivantes : « Une femme dans un café travaillant sur son ordinateur portable avec des écouteurs, peinture d’Alphonse Mucha », bien sûr, c’est un tableau qui n’existe pas. Pourtant, l’image qui a été générée est bien celle d’une femme, avec un ordinateur portable et des écouteurs, dans un style historique reflétant celui d’Alphonse Mucha.

Il y a maintenant un potentiel incroyable de création de dialogue entre un humain et une machine pour aboutir à un résultat créatif.

Les images sont en fait le résultat d’un générateur très sophistiqué de nombres aléatoires. Bien que l’accès à DALL-E soit limité pour éviter la prolifération d’images toxiques, les capacités de création de dialogue entre un humain et une machine pour aboutir à un résultat créatif sont impressionnantes. Cela pourra conduire à l’essor des agences virtuelles.

Dave Wright : L’IA grand public est omniprésente. Pensez-vous qu’il existe un grand fossé entre l’IA grand public et l’IA des entreprises ?

Nicolas Chapados : Oui, cela fait plus longtemps que le grand public consomme de l’IA par rapport aux entreprises. Les plus gros investissements en R&D dans l’IA ont été fait par des marques grand public : Meta, Google, etc. C’est d’ailleurs l’expérience des utilisateurs grand public, largement déterminée par l’IA, qui a façonné les attentes en matière d’IA d’entreprise, notamment en termes d’expérience client. Le monde de l’entreprise ne sera pas trop devancé sur ce point.

D’ailleurs, réseaux sociaux, les emails, des documents et même des œuvres d’art pour créer de nouveaux modèles. Par exemple, un système pourra s’inspirer du design et de la conception d’éléments existants dans l’entreprise pour produire des contenus qui auront les mêmes caractéristiques que ceux réalisés par son équipe marketing. Des startups mettent au point des outils d’IA qui s’appuient sur des publications et des contenus tels que les réseaux sociaux, les emails, des documents et même des œuvres d’art pour créer de nouveaux modèles. Par exemple, un système pourra s’inspirer du design et de la conception d’éléments existants dans l’entreprise pour produire des contenus qui auront les mêmes caractéristiques que ceux réalisés par son équipe marketing.

Il existe d’autres exemples de l’émergence de l’IA dans l’entreprise mais ils n’en sont encore qu’à leurs prémices. Je pense que nous commençons tout juste à envisager les diverses applications de l’IA générative et les différents cas de son utilisation en entreprise.