Il est de bon ton de vouloir comparer les grandes puissances telles que la Chine et les USA au regard de leur dominance dans ce vaste champ technologique qu’est l’intelligence artificielle et de se demander comment la France et l’Europe pourraient devenir des « leaders » de ce marché. Comme si l’IA était un marché monolithique où un pays pouvait gagner une telle bataille d’un seul bloc. L’image est plus nuancée que cela. L’IA est une nouvelle vague de l’histoire de l’informatique comme l’ont été l’Internet ou la mobilité, avec une myriade d’acteurs globaux et locaux. Elle traverse tous les secteurs d’activité.

Les batailles industrielles de l’intelligence artificielle (IA) concernent la recherche avancée, les processeurs, les ressources du cloud, les assistants vocaux, la collecte et l’exploitation de données personnelles ou industrielles, la médecine prédictive et les véhicules autonomes pour n’en prendre que quelques exemples. Ces batailles se démultiplient également dans tous les marchés horizontaux et verticaux. A chaque fois peuvent y émerger de nouveaux acteurs ou se consolider la position d’acteurs existants. Le marché de l’intelligence artificielle présente la particularité d’associer des architectures matérielles de nouvelle génération utilisant des processeurs dits neuromorphiques, des algorithmes mettant en œuvre des mathématiques avancées et des données qui servent à alimenter des modèles prédictifs.

L’histoire de l’informatique et du logiciel est pleine d’enseignements. Certains événements du passé pourraient se reproduire, comme l’émergence de plateformes dominantes, la démocratisation des outils et la prolifération d’activités de services. La valeur générée par l’IA sera tout aussi diffuse et distribuée sur un grand nombre d’acteurs industriels, des acteurs mondiaux avec de fortes économies d’échelle et des acteurs locaux, portés sur le service et l’intégration. Est-ce que le statu quo actuel qui voit la dominance des USA côté logiciels et Internet et celle de l’Asie côté matériel perdurera ? L’Europe voudrait bien récupérer sa part du gâteau mais il semble qu’elle ne sera pas plus importante que celle qu’elle récupère dans les industries numériques d’aujourd’hui. Elle risque même d’être réduite à la portion congrue, car le Vieux Continent est pris en sandwich entre les USA et la Chine, cette dernière ayant des velléités de ne pas jouer un rôle de figuration dans la fabrication de matériel. Nous allons ici explorer quelques-uns de ces enjeux des batailles industrielles de l’IA, ceux de la recherche, du matériel, des données et des véhicules autonomes et identifier quelques-uns des acteurs français qui y jouent un rôle de premier plan.

Une recherche ouverte

L’excellence des chercheurs français est souvent mise en avant pour justifier le rôle de la France dans le marché de l’IA. Ils sont en effet les troisièmes plus grands contributeurs en publications scientifiques après les Américains et les Chinois. Mais cela ne suffit évidemment pas pour transformer cette performance intellectuelle en atout économique. On pourrait même voir se reproduire un scénario que l’on a connu ces quinze dernières années avec l’open source. Les chercheurs français en étaient à la fois des champions et de grands contributeurs mais force est de constater que cela n’a pas eu d’impact économique majeur et compétitif pour l’industrie française du logiciel. L’impact a été au mieux plutôt indirect.

Aux USA, ceux qui ont tiré leur épingle du jeu étaient des acteurs dont le modèle économique était périphérique à celui du logiciel comme le service pour IBM ou la publicité pour Google et Facebook. Les plus grands éditeurs « pure player » du logiciel libre sont aussi américains, Red Hat en tête. L’open source a bien été utilisé dans l’industrie, dans le web et le commerce en ligne et dans le cloud en général, mais cela n’a pas permis pour autant de créer des acteurs de référence mondiaux du secteur à part quelques rares exceptions telles que l’éditeur de logiciel open source français Talend, spécialisé dans le traitement de données. Ce phénomène pourrait très bien se reproduire avec l’IA. Il pourrait même être accentué par le poids économique des données qui est tout aussi important que celui des algorithmes et des logiciels d’IA.

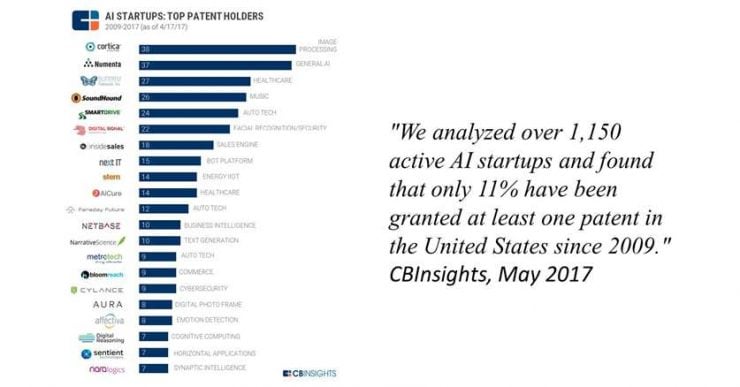

Les solutions de l’IA bénéficient en effet de nouveaux travaux de recherche publiés régulièrement partout dans le monde. Ils sont généralement accompagnés d’exemples de code permettant de se les approprier rapidement. La propriété intellectuelle associée à ces travaux est variable mais requiert de la vigilance pour ceux qui la réutilisent. La société d’études américaine CBInsights remarquait ainsi en mai 2017 que seulement 11% des start-up de l’IA identifiées dans leur base avait déposé au moins un brevet. Cela signifie que la partie algorithmique des applications de l’IA est déjà une commodité sans forcément avoir de valeur marchande.

On peut par exemple le constater avec les nombreuses start-up qui font de la reconnaissance de pathologies diverses dans l’imagerie médicale ou celle d’individus dans les systèmes de surveillance vidéo. Les start-up du secteur utilisent toutes les mêmes méthodes de réseaux convolutifs inventées il y a une vingtaine d’années par Yann LeCun. Ces méthodes évoluent dans le temps pour être plus performantes et reconnaître des images de plus en plus complexes, mais elles restent communes à la plupart des sociétés qui les emploient. Rares sont les start-up qui ont un véritable avantage compétitif de ce point de vue-là.

Les chercheurs ne restent bien évidemment pas les bras croisés. Le champ de l’IA est éminemment vaste. Les travaux les plus avancés concernent les systèmes d’aide à la décision, allant dans le sens de la création d’intelligences artificielles généralistes, ces mythiques AGI (Artificial General Intelligence) capables de raisonnement généraliste à même de résoudre les problèmes les plus complexes. D’autres travaux portent sur le traitement du langage qui reste encore balbutiant malgré les prouesses des agents conversationnels et vocaux.

Dans l’entrepreneuriat, le temps est une matière première encore plus rare que les financements. La question qui se pose aux décideurs français n’est donc pas de simplement mieux organiser la recherche, de mieux rémunérer les chercheurs pour qu’ils ne partent pas à l’étranger et les faire travailler ensemble et avec les entreprises. La bataille est plutôt celle de la fluidité des idées et des cerveaux, pour que ceux-ci œuvrent le plus rapidement possible à créer des applications concrètes de leurs travaux de recherche.

L’IA dans le matériel

Dans l’IA, le matériel joue un rôle clé et complémentaire aux algorithmes et aux données. Il l’est d’autant plus que nombre d’applications stratégiques de l’IA sont très gourmandes en ressources machines, notamment dès qu’elles s’appuient sur des réseaux de neurones complexes dans ce que l’on appelle communément l’apprentissage profond, ou deep learning. Ces réseaux profonds servent en particulier aux applications de reconnaissance d’images, du langage et à l’analyse de données complexes.

L’industrie des semi-conducteurs est actuellement mobilisée pour créer des composants spécialisés dans l’entraînement et l’exécution de réseaux de neurones pour les applications d’intelligence artificielle. Ils sont déployés dans les serveurs où l’entraînement de réseaux de neurones s’appuie sur de grandes bases de données ainsi que dans les objets connectés de toutes sortes et dans les smartphones.

Ce marché est pour l’instant dominé par l’Américain Nvidia, dont les GPU intégrant des unités de calcul neuromorphiques équipent aussi bien les serveurs de data-centers que des caméras de surveillance ou des cartes électroniques pour véhicules à conduite assistée ou autonome. Nvidia est une société étonnante créée en 1993 qui s’est d’abord installée comme le leader des processeurs graphiques pour PC, les GPU, puis s’est diversifiée avec succès dans les serveurs, les data-centers, l’équipement automobile et plus récemment, dans l’intelligence artificielle. La société fait un chiffre d’affaires de plus de $8B, soit à peu près la taille du franco-italien STMicroelectronics.

Nvidia est talonné par Intel qui a diversifié son approche dans l’IA avec ses processeurs pour serveurs Xeon Phi, ses processeurs neuromorphiques Nervana issus d’une acquisition datant de 2016, des processeurs pour les objets connectés avec Movidius, également une acquisition de 2016 et enfin, l’annonce de processeurs spécialisés Loihi. Le tout est très brouillon, au minimum d’un point de vue marketing.

Lors du CES de Las Vegas, en janvier 2018, étaient annoncés des processeurs mobiles intégrant des unités de traitement neuromorphiques capables d’exécuter des réseaux de neurones entraînés pour la reconnaissance d’image ou de la parole, notamment chez Mediatek et Via. Cela s’inscrivait dans la lignée du processeur Kirin 970 que Huawei avait annoncé en septembre 2017 et qui équipe les derniers smartphones Huawei Mate 10 et Honor View 10. Pour la petite histoire, Huawei s’est appuyé sur la start-up chinoise Cambricon Technologies pour concevoir cette unité de traitement neuromorphique. Cette start-up a été financée par un fonds du gouvernement chinois à hauteur de $100M.

Au CES 2018, STMicroelectronics présentait aussi un microcontrôleur neuromorphique très efficace en rapport puissance/consommation, et dédié aux objets connectés, là où la consommation énergétique doit être la plus basse possible.

Au juste, quelle intelligence est intégrée dans ces processeurs et unités de traitement neuromorphiques ? Il s’agit principalement de simples multiplicateurs de matrices de nombres entiers ou flottants de petite taille (3×3 ou 4×4). Ces multiplicateurs correspondent aux principes mathématiques de base du fonctionnement des réseaux de neurones artificiels du deep learning. Ils doivent accéder à une mémoire rapide et consommer le moins d’énergie possible.

Les techniques de fabrication de ces processeurs neuromorphiques sont les mêmes que celles les processeurs traditionnels. Elles sont surtout maîtrisées par les Américains Intel et Global Foundries et par les fabs asiatiques chez Samsung et TSMC.

Et les industriels français ? Ils sont présents sur ce marché avec les microcontrôleurs de STMicroelectronics, les solutions embarquées dans les objets connectés de Scortex, les capteurs vidéo neuromorphiques de Chronocam, et Kalray qui vise le marché automobile avec ses processeurs multicore. La technologie FD-SOI de STMicroelectronics est un atout pour la fabrication de chipsets neuromorphiques car elle assure un fonctionnement optimal et une basse consommation d’énergie. Dans la pratique, cette technologie s’appuie sur l’utilisation de galettes de silicium dopées avec un isolant à base d’oxyde de silicium et fabriquées par le Français SOITEC à côté de Grenoble. Elle est complétée par des brevets détenus par le laboratoire de recherche public CEA-LETI et par STMicroelectronics. La technologie est utilisée sous licence par Samsung et Global Foundries.

La bataille est rude autour de ces processeurs mais ce qui qui compte n’est pas situé que dans leur conception et dans leur fabrication. Elle est plutôt située dans les briques logicielles associées. La dominance de Nvidia provient ainsi non pas simplement de ses processeurs mais de son architecture CUDA qui est très largement supportée par les créateurs de bibliothèques logicielles pour la 3D et pour l’IA, et notamment la bibliothèque TensorFlow de Google qui domine actuellement le champ du machine learning et du deep learning.

Une autre bataille encore plus rude se profile à l’horizon : celle des ordinateurs quantiques. La recherche bouillonne dans le domaine, avec encore de grands acteurs américains tels que IBM, Intel, Microsoft et Google, souvent associés à des laboratoires de recherche européens comme l’Université de Delft aux Pays-Bas pour Intel. Le CEA et ATOS sont investis sur le sujet mais le font-ils avec des visées mondiales ou des ambitions limitées ? Or, il se trouve que les ordinateurs quantiques progressent rapidement. On en est à une cinquantaine de qubits pour l’instant, ces unités de traitement élémentaires capables de gérer plusieurs états simultanément grâce à la superposition quantique des états de photons ou d’électrons. Quand cette limite sera franchie, les possibilités du quantique seront extraordinaires dans de nombreux domaines comme pour la cryptographie, l’entraînement de réseaux de neurones complexes et surtout la création d’outils de simulation dans la physique des matériaux et dans le vivant.

La commande vocale

La commande vocale donne lieu à une bataille homérique qui met en jeu les GAFAM : Google et son Assistant, Amazon avec Alexa, Apple avec Siri et Microsoft avec Cortana. Facebook est un peu en retrait mais sa plateforme Messenger est le réceptacle d’une grande majorité des chatbots textuels actuellement développés.

Le CES 2018 marquait la fin de l’hégémonie d’Amazon avec la montée en puissance de l’écosystème de Google et de son Assistant. Google avait investi très gros sur ce CES pour rattraper son retard face à Alexa avec un stand en extérieur sur Central Plaza, des visuels sur le monorail de la ville de Las Vegas passant devant le salon et sur presque tous les billboards à LED géants de la ville. Ils avaient acheté leur visibilité comme ils ne l’avaient jamais fait dans cet événement, leur dernière présence remontant à 2006, à l’occasion d’une intervention en keynote de leur cofondateur Larry Page. Leur stand de l’époque était modeste.

Un décompte objectif montrait qu’Amazon Alexa avait encore le dessus sur Google Assistant en nombre de produits le supportant. On est donc face à un duopole d’agents conversationnels. Les autres comme Apple Siri, Microsoft Cortana, Samsung Bixby ou le récent Baidu DuerOS, ciblant d’abord le marché chinois, semblent marginalisés dans l’écosystème. Bien entendu, les Chinois du secteur se feront fort d’essayer de conquérir les marchés occidentaux dès que possible. Jusqu’à présent cependant, les leaders américains semblent avoir encore le dessus.

Il existe d’autres solutions de traitement de la parole indépendantes des GAFAM et faites pour être intégrées en marque blanche dans des produits tiers, comme celles des Français Snips et XBrain et des Américains Nuance et SapientX, qui sont surtout utilisées dans l’automobile.

La bataille des assistants vocaux prend la forme d’une bataille de plateformes techniques et d’intermédiation comme on en a déjà connue avec celle des systèmes d’exploitation pour PC et mobiles. Ici, la commande vocale est un intermédiaire entre les services et l’utilisateur. La plateforme assure les fonctions de compréhension du langage et le lien avec les fonctions des services associés, notamment pour piloter des objets connectés. Suivant la fameuse loi de Metcalfe, plus les assistants vocaux sont supportés par un nombre croissant d’objets et fonctions, plus grande est leur valeur. On ne va en effet pas passer d’un assistant vocal à l’autre pour commander la myriade d’objets connectés de sa maison. Cela explique d’ailleurs un partenariat entre Amazon et Microsoft pour rendre interopérables Alexa et Cortana.

Ce passage du produit à l’usage est séduisant pour l’utilisateur mais il génère un nouveau casse-tête marketing pour les fournisseurs. Ils risquent de perdre leur marque et leur identité. Ils devront réinventer une communication vocale préservant leur identité et leur marque sous peine d’être nivelés par les plateformes vocales les accueillant.

L’intelligence artificielle au service des objets connectés

L’IA ne se résume cependant pas à la commande vocale ! Elle sert à la reconnaissance d’images dans la vidéo-surveillance ou la santé et représente, par exemple, une opportunité de plus de régler un problème lancinant des objets, notamment dans la maison connectée : la complexité de leur coordination.

Des sociétés comme IFTTT s’y sont essayées avec plus ou moins de bonheur, en permettant de programmer des actions dans une application mobile et sans faire appel à de l’IA. L’air du temps est aux systèmes intelligents qui apprennent par eux-mêmes en observant les tâches lancées manuellement par les utilisateurs afin de les automatiser comme chez la start-up française Ween.ai. L’idée est simple : plutôt que de répéter plusieurs fois des séquences de commandes vocales, pourquoi la maison connectée ne détecterait pas d’elle-même nos habitudes pour déclencher automatiquement les bonnes actions en fonction du contexte ?

C’est aussi ce qu’essaye de faire LG Electronics avec sa ThinQ AI, sa marque ombrelle des produits blancs et bruns qui intègrent de l’IA qui sont interopérables. L’IA chez LG touche jusqu’au système d’air conditionné Dualcool ThinQ Stand Inverter Air Conditioner qui peut maintenant être commandé par la voix, le tout associé au DeepThinQ AI qui envoie l’air vers les personnes détectées dans la pièce.

On voit aussi émerger de plus en plus d’IA émotionnelle. D’abord, avec les capteurs vidéo et audio qui détectent et analysent les émotions des utilisateurs, notamment à la maison. Puis qui en tiennent compte pour adapter l’ambiance comme au niveau de l’éclairage ou des contenus proposés aux utilisateurs. Dans ce domaine, la start-up new-yorkaise Emoshape, créée par le Français Patrick Levy-Rosenthal et soutenue par Orange Silicon Valley, présentait au CES 2018 son composant électronique Emotion Processing Unit (EPU), destiné à capter les émotions des utilisateurs.

La start-up Beyond Verbal qui était présente sur le pavillon israélien est de son côté spécialisée dans la détection des émotions dans la voix. Une chose que fait aussi la start-up parisienne Batvoice qui équipe notamment les centres d’appels.

Quel futur tout ceci préfigure-t-il ? Un futur où nous nous laissons guider en permanence par les machines et où le cerveau n’a plus de temps libre ou, au contraire, où il est laissé en jachère par une bonne partie de la population ? En tout cas, ces IA vont poursuivre la modification en profondeur de notre relation au temps, une relation qui va changer avec ces outils qui nous assistent et nous disent quoi faire à tous les instants.

D’un point de vue industriel, l’IA pourrait aussi se révéler être la technologie clé qui permettra à la maison connectée d’être enfin un marché en forte croissance.

La robotique de services

Les robots étaient très présents dans cette édition 2018 du CES, avec quelques robots de services intéressants comme le pédibus-jambus d’Ubtech ou la nouvelle mouture du chien Aibo de Sony avec ses élégants mouvements et câlines réactions aux utilisateurs.

Notons que le Chinois Ubtech, qui a notamment copié sans vergogne le Nao d’Aldebaran, a levé un total de $520M dont $100M en 2017. C’est donc largement une licorne de la robotique ! Un autre Chinois, Roobo, a levé un total de $152M. Il est à l’origine d’une grande famille de robots comprenant le BeanQ, le PuddingS, le Farnse, le Jelly, le Domgy et un chipset ChipIntelli.

L’offre des robots de services commence à s’élargir. Honda lançait une série de concepts de robots 3E (Empower, Experience, Empathy) qui sont destinés à améliorer la mobilité, notamment des seniors. Il y avait notamment 3E-A18 (compagnon doué d’émotions dans les expressions du visage, comme Sophia de Hanson Robotics), 3E-B18 (chaise roulante d’intérieur et extérieur), 3E-C18 (véhicule électrique) et 3E-D18 (véhicule autonome).

Et les robots de services français ? Il nous en reste quelques-uns après la digestion consommée d’Aldebaran Robotics par le Japonais Softbank. Nous avons par exemple le Lyonnais Hease Robotics, le Rouennais Event Bots et le Francilien Partnering Robotics avec leurs robots de services pour l’espace public, A.I.Mergence et son petit robot de surveillance E4 et Blue Frog Robotics et son Buddy. Mais lesquels de ces robots deviendront de véritables plateformes ?

Qu’est-ce qui manque à tous ces robots ? Cela dépend du besoin. Quand il s’agit de robots dont la première fonction est d’établir une conversation, comme dans pas mal de robots de services, il s’agit d’y intégrer des chatbots capables de comprendre le contexte et le sens d’un champ large de questions et d’y répondre.

Lorsqu’il s’agit de robots devant interagir mécaniquement avec leur environnement, le défi est lié aux capteurs, à l’interprétation de leurs données et aussi aux actuateurs et autres moteurs qui permettent aux robots de saisir des objets, les porter, les manipuler. L’équivalent de la main humaine avec sa versatilité n’est pas encore vraiment là.

En dernier lieu se pose la question de la source d’énergie, en général sous forme de batteries, et de leur densité énergétique. Un problème commun à celui des smartphones comme des véhicules électriques et qui mobilise bien l’industrie des batteries.

Les plateformes automobiles

L’IA est aussi intégrée dans une bataille industrielle émergente : celle des plateformes destinées aux véhicules autonomes. C’est un enjeu industriel critique pour la prochaine décennie. Il met en jeu des constructeurs, des équipementiers tels que les Français Valeo et Faurecia, des concepteurs de composants comme Nvidia, des éditeurs de logiciels tels que QNX, des plateformes en cloud telles que celles de Google et HERE. Aucun acteur ne semble prêt à maîtriser cette chaîne de valeur complexe de bout en bout. Elle s’horizontalisera sans doutes avec quelques acteurs leaders pour chacune de ces couches techniques. Mais à chaque étage, l’enjeu sera un mélange de capteurs, de processeurs, de données et de logiciels.

La stratégie du moteur de recherche chinois Baidu mérite le détour de ce point de vue là. Il en est à la seconde version de sa plateforme logicielle open source de conduite autonome Apollo 2.0. Elle ajoute des fonctions de sécurisation de la conduite grâce à une meilleure prise en compte des capteurs du véhicule et du planning de la conduite.

Le tout s’appuie sur des services en cloud, une plateforme logicielle embarquée et une plateforme matérielle de référence. Baidu s’enorgueillit d’avoir accumulé 165 000 lignes de code, ce qui n’a pourtant rien d’extraordinaire. Côté matériel, Apollo 2.0 supporte les chipsets de Nvidia, Intel, NXP et Renesas.

Pour accélérer l’adoption de sa plateforme, Baidu travaille avec le gouvernement de Singapour et a créé un fonds d’investissement de $200M pour développer les usages de la conduite autonome dans l’Asie du Sud-Est. Il est aussi partenaire d’Access Services, une agence de transports publics de Los Angeles pour lancer un pilote de trajets de courte durée d’ici fin 2018. En Chine, Baidu est partenaire du constructeur Xiamen King Long United Automotive Industry pour produire des bus autonomes et avec Chery Automobile pour des voitures de niveau 3 en 2020. Ils travaillent aussi avec JAC Motors et BAIC Motor.

Par certains côtés, Baidu semble en avance par rapport à Google et sa filiale Waymo. Dans l’histoire récente, Google s’est plutôt comporté comme un constructeur émergent, intégré verticalement et cherchant à créer ses propres véhicules. On peut imaginer que Google deviendra à terme un fournisseur de plateforme logicielle embarquée et en cloud, celle qui leur assurera les meilleures économies d’échelle. Or dans le cas présent, Baidu semble avoir attaqué ce marché de manière plus directe et, qui plus est, avec nombre de partenariats avec des équipementiers et constructeurs du monde entier, qui sont au minimum appâtés par la perspective d’aborder par ce biais le marché chinois.

On peut aussi être impressionné par le travail de Byton, cette start-up associant des Chinois, des Américains et des Allemands, ces derniers provenant de BMW. En décembre 2017, la start-up annonçait sa berline électrique à conduite assistée puis, à terme, autonome. Les concepteurs de ce véhicule ont réfléchi à de nombreux aspects et scénarios de son usage et le lien entre véhicule et mobile, le partage du véhicule et sa personnalisation. Doté d’un écran géant de 1,25 m de large, il ressemble à un concept car et pourtant son lancement est prévu d’ici 2019. Byton est une marque de la start-up chinoise Future Mobility et qui a levé $200M pour commencer, notamment auprès de Tencent et Foxconn.

Ford est un constructeur qui a adopté un positionnement intéressant. Il se positionne à terme plus comme un opérateur de plateforme de véhicules et un partenaire d’opérateurs de services qu’en simple constructeur, le tout en se souciant de la bonne intégration des véhicules dans la ville intelligente. Comme Byton, Ford entrevoit un monde où les voitures seront de plus en plus mutualisées au niveau de plateformes de services au lieu d’être possédées par les foyers. L’Américain Uber anticipe également cette échéance, ayant déjà commandé des milliers de voitures autonomes à Volvo. Il en va ainsi de Lyft qui expérimentait au CES de Las Vegas des véhicules autonomes BMW réalisés en partenariat avec l’équipementier Aptiv, anciennement Delphi.

Baidu, Byton, Uber, Lyft et Ford sont tous des témoins des bouleversements qui pourront affecter l’ensemble de l’industrie automobile, l’IA étant une des technologies clés déclenchante de tous ces mouvements.

La bataille des données

On résume souvent les batailles industrielles de l’IA aux données, en faisant surtout allusion à la capacité gargantuesque de leur accumulation par les géants de l’Internet. S’il est vrai que les GAFA disposent de tombereaux de données sur les faits et gestes des consommateurs, leur valeur est surtout publicitaire.

Les usages de l’IA couvrent heureusement bien plus de domaines que cela et il faut éviter de considérer que tout est perdu face aux GAFA. Les IA peuvent être alimentées par une grande diversité de données issues de tous les secteurs d’activité : qu’ils soient industriels, environnementaux, liés aux services publics, juridiques, et aussi liés aux données médicales et pas juste sur les capteurs reliés aux smartphones.

Nombre de ces données ont de la valeur pour créer des applications d’IA puissantes, qu’il s’agisse de faire des prévisions, de segmenter ses marchés, d’analyser des textes ou d’aider à prendre de bonnes décisions. La force des données se révèle lorsqu’elles sont combinées, notamment pour découvrir des éléments de corrélation entre données disparates. Les données isolées ont donc moins de valeur que leur assemblage. C’est une cuisine nouvelle qui prend forme et qui ouvre des portes de création de valeur pour tous les acteurs innovants de tous les secteurs d’activité.

Encore faut-il que ces données puissent être captées et exploitées, tout en respectant les réglementations qui protègent la vie privée des citoyens et consommateurs. Elles ont aussi une valeur qui dépend de leur couverture géographique. Comme pour les plateformes, la collecte de données à l’échelle mondiale est seule garante de la création de leaders mondiaux.

La bataille des compétences

Le dernier enjeu est celui des compétences techniques de l’IA. Les ingénieurs et data scientists maîtrisant l’IA sont rares et chers et la pression va s’accentuer avec l’adoption progressive de l’IA par les entreprises. Les développeurs sont déjà des ressources rares dans tous les écosystèmes d’innovation. Avec l’IA, la pression va s’accentuer. D’où l’impératif de la formation, surtout supérieure, des ingénieurs et mathématiciens qui feront notre compétitivité. Le plan France IA avait repéré quelques centaines de cursus formant environ 1200 personnes par an. C’est évidemment insuffisant et l’enseignement supérieur tant public que privé devra se mobiliser pour faire évoluer ses cursus.

Il en va de même d’une autre bataille, politique, qui est celle de l’immigration qualifiée. La chasse aux talents n’est pas que verticale entre classes d’âges. Elle est transnationale. Les USA étaient connus pour vampiriser les talents mondiaux, notamment dans leurs grandes universités telles que Stanford. La période Trump semble ralentir le phénomène et offrir une opportunité aux pays qui sauront saisir la balle au bond. S’il est vrai que la plumée des talents d’autres pays n’est pas forcément de bonne guerre, il a un impact positif certain sur la compétitivité : il favorise l’ouverture des entreprises françaises sur le monde.

Simultanément, un autre enjeu se fera jour. De nombreux éditeurs de logiciels ambitionnent de créer des solutions démocratisant l’accès à l’IA dans les entreprises, notamment pour le machine learning utilisé dans l’exploitation de données structurées. L’outillage qui est réservé aujourd’hui aux spécialistes deviendra probablement plus simple d’emploi et accessible au plus grand nombre, à commencer par les cadres, comme l’ont été les outils bureautiques et de création inventés depuis les années 1980. Là aussi, il y a de nombreuses opportunités d’être innovant et compétitif.

Dans la pratique, l’IA sera surtout intégrée dans des solutions complexes relevant de l’innovation par l’intégration. Elle sera de plus en plus associée aux objets connectés qui captent des données ainsi qu’aux avancées des télécommunications, notamment la 5G. L’IA n’est pas un domaine isolé des autres dans le numérique. Il fait partie d’un ensemble riche de technologies qui, bien utilisées, ouvriront la porte de la croissance aux plus innovants et au plus ambitieux.

Par Olivier Ezratty

Vous avez aimé cet article ? Likez Forbes sur Facebook

Newsletter quotidienne Forbes

Recevez chaque matin l’essentiel de l’actualité business et entrepreneuriat.

Abonnez-vous au magazine papier

et découvrez chaque trimestre :

- Des dossiers et analyses exclusifs sur des stratégies d'entreprises

- Des témoignages et interviews de stars de l'entrepreneuriat

- Nos classements de femmes et hommes d'affaires

- Notre sélection lifestyle

- Et de nombreux autres contenus inédits